-随想-

人不能,至少不可以 …… 放弃学习、好奇心和进步。

眼观各路媒体炒作 ChatGPT 有感。

不是说要努力加油不被淘汰这种,这种是一方面,人天资品赋各有不同能力后天习得多少不能强求。

比较反感的是太多的贩卖焦虑,而且带出一种悲观情绪,学这个没用,当那个没前途,什么都没用。遁入了虚无主义。

放心,AI还会进步,但GPT不会炒作太久的,你看现在还有人提石墨烯吗?还有人提元宇宙吗?

结论:

人不能,至少不可以 …… 放弃学习、好奇心和进步。

眼观各路媒体炒作 ChatGPT 有感。

不是说要努力加油不被淘汰这种,这种是一方面,人天资品赋各有不同能力后天习得多少不能强求。

比较反感的是太多的贩卖焦虑,而且带出一种悲观情绪,学这个没用,当那个没前途,什么都没用。遁入了虚无主义。

放心,AI还会进步,但GPT不会炒作太久的,你看现在还有人提石墨烯吗?还有人提元宇宙吗?

结论:

确定最近没有受盗梦空间 和类似 VR题材电影的影响。又一个情节比较清洗丰富的梦趁着印象没有逐渐消退之前记录一下。

我似乎是个少年,被挖掘还是被家人安排记不清了,跟着一个像星探的样子的人进入了一所园林样子的武校。这所学校主要培养的是武学人才,没有那种神怪修仙的设定,大概是类似体校输出的是参加武术比赛的人才。

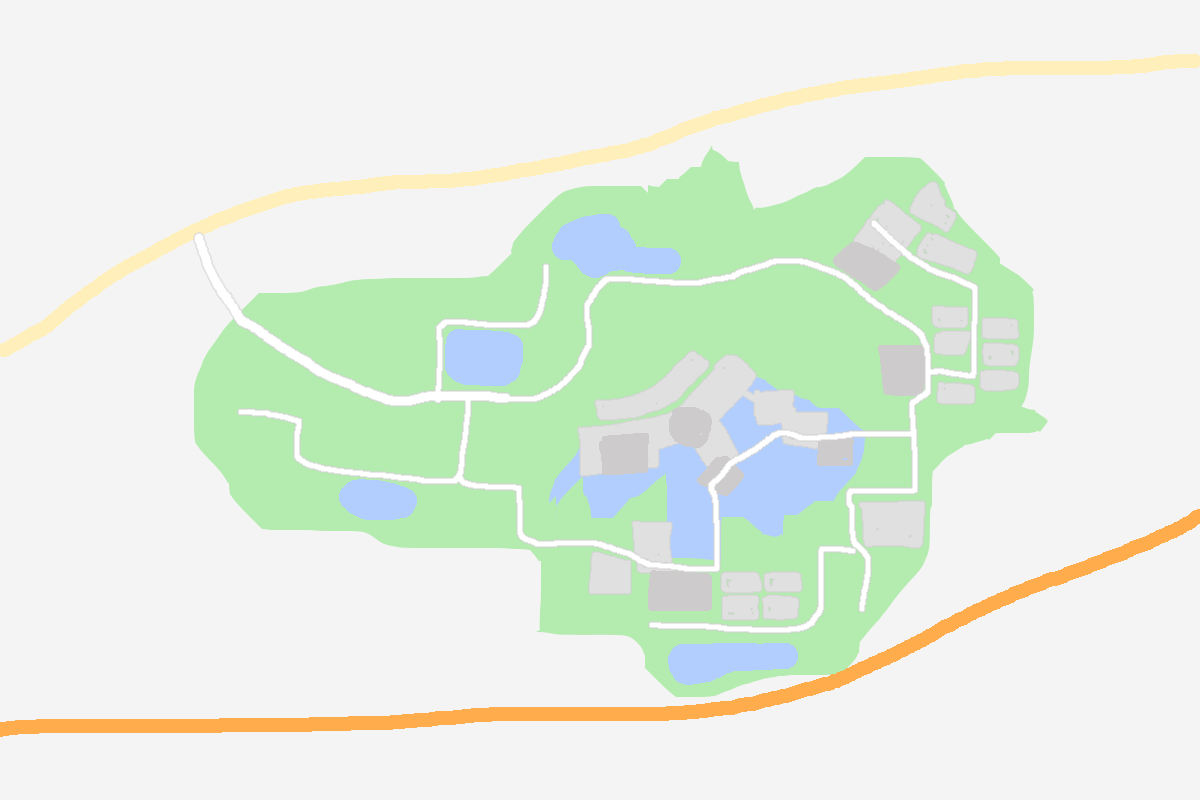

中介人把我介绍给了一个魁梧的男子,说他以后就是我的教练了。他带我走了一圈学校的环境。一路上曲折迂回有几个片区,分别是不同年级或者水平的师兄师姐的练功场,中间会经过一个很大的湖,湖上有桥廊湖畔又一个很大的宫殿状的建筑是院校的主楼。整个园区是封闭式的,只有一条道连接到外部的公路上。

修炼的日子极其辛苦,时间一晃多年。我随着几位师兄师姐初次外出参赛。在比赛前夕,我忽然冒出一个疑惑,问同行的师姐:XXX,你记得我们教练叫什么名字吗?明明是相处了多年,我怎么都想不起来了,好奇怪....

师兄师姐们仔细思索了一下,也皱起了眉表示想不起来。我们就打开了笔记本电脑查了起来,认为学校一定网上有官网有介绍,也会有师资名单之类的。奇怪的是没有查到什么东西,倒是搜地图,找到了院校所在的地方。这地方看卫星图和我们印象中的一模一样,但标注的却不是学校而是一个开放的景区,名字也和学校完全没有关系。此时我冒出了更多的疑问

带我们来的那个老师叫什么名字?我记得她名字是三个字的...现在好像也想不起来了

我们学校叫什么名字来着?

身边的师兄师姐师弟师妹的脸逐渐模糊....?

我闪过一个念头:我的记忆是被注入的,这些没法回答的问题是我触及了记忆边界!?

这是在做梦!清醒地意识到自己在梦里...但确没有立刻醒来..也没有留在梦中的世界。

可惜了,还想试试梦里为所欲为...但四周褪色沉寂了下来剩下寂静。

我在那做着片刻的思考...回想我最初的记忆是从哪里开始的..跟自己说要把学校的地图的样子记住,醒来后把它画下来,要记住这个景区的名字

然后我睁开了眼睛...终究醒来没多久还是忘记了大部分具体的姓名和学校、景区的名字,只有抽象的地图我记住了

要在一个微信页面上实现录音功能,要求不复杂,一个录音按钮按下开始录音,松开停止(并上传保存)。

以为jq本身对移动端的交互事件支持和优化不够 一开始被 jQuery MOBILE 插件给误导了

研究了半天的 .on("tap") 点按和 .on("taphold")长按,但是没有找到手指离开屏幕的事件,而且触发的顺序总是很奇怪

而且jq mobile 很坑的一个绑定的 css 样式,会令我原有的页面样式搞的支离破碎。

绕回原点发现根本没有那么麻烦,用jq自己的 touchstart 和 touchend 不需要额外的插件。

$("#btn_rec").on("touchstart mousedown",function(){

rec_start();

});

$("#btn_rec").on("touchend mouseup",function(){

rec_end();

});顺带追加一个关于微信 jssdk 录音功能备忘:

文档 https://developers.weixin.qq.com/doc/offiaccount/OA_Web_Apps/JS-SDK.html#23

没有难度,照搬代码就能实现上文的业务功能。

执行顺序分别是

wx.startRecord() 开始录音(第一次执行会询问授权)wx.stopRecord() 停止录音 或 wx.onVoiceRecordEnd() 超60秒自动停止,获得本地资源idwx.uploadVoice() 上传本地资源,换领微信服务端临时素材资源id (暂存3天)需要备忘的是:wx.onVoiceRecordEnd() 只有录制达到60秒的时候自动停止才会触发。它并不是主动停止录音 stopRecord 会回调的事件。

总结:

客户要做代发微信红包的活动,无一例外地招来黑产的攻击盗刷作弊。

和黑产斗智斗勇内耗严重。

活动数据始终容易被伪造,所以思路最后还是落在增加他们的违法成本上,让其食之无味知难而退。

主要方式是针对可疑的IP建立黑名单机制,因为更换IP或者找寻特定地理位置的代理的IP成本极高,即使它们在目标地区,更换动态IP也能减缓其速度。

需求前提铺垫到此为止,以下是实现过程。

考虑到这种查库存在误差和过时失效等精确度的问题。IP归属地和 手机号码归属地进行结合判定,提高判断结果的可信程度。

手机上一些录制的视频想传电脑上不想经过 QQ之类,想着用miui自带的米传功能,没想到踩大坑。害我全屋的wifi设备大面积掉线

一开始还以为是管wifi的无线路由器坏了,

路由IP都从 192.168.0.1 变成了 192.168.137.1

想想不对啊,我路由和 AP是分体的,而且 AP有两台

连第二台AP(无线路由运行在中继模式)的,还是一样的问题!?

一开始没往这个IP的方向去想,以为AP坏了,又去检查路由,把路由重启过,重设DHCP过,把AP给重启过还初始化恢复出厂过...都不行。

白折腾了AP和路由

最后追查下192.168.137.1 竟然是我正在用的台式电脑。

回想起出问题前安装了米传这个坑爹的东西,原理是把自己所在的电脑的网络适配器(网卡)套上一个路由服务,而且强制广播强行接管所有DHCP,于是所有没设置的AP丢弃原本的路由,改拜米传软件做路由!向我的台式电脑请求internet怎么可能会通!

艹!什么白痴玩意!